Web Scraping vs. Web Crawling: Entender la diferencia

Anda Miuțescu el 01 Jul 2021

¿Qué fue primero? ¿El rastreador web o el raspador web?

Depende de cómo se diferencie entre extracción y descarga. El web scraping no siempre requiere el uso de Internet. La extracción de información de un sistema local, una base de datos o el uso de herramientas de raspado de datos puede denominarse recopilación de datos. Mientras tanto, los rastreadores web se encargan principalmente de hacer una copia de todos los sitios a los que se accede para su posterior procesamiento por parte de los motores de búsqueda, que indexarán las páginas guardadas y buscarán rápidamente las páginas no indexadas.

Este artículo pretende explicar las diferencias y co-funcionalidades del web scraping, crawling, y todo lo que hay en medio. Como extra, hemos incluido una guía en profundidad sobre cómo construir tu propio rastreador web, ¡así que sigue leyendo!

¿Qué es el web scraping?

El web scraping, también conocido como extracción de datos, es el proceso automatizado de recopilación de información estructurada de Internet. Este término abarca un amplio abanico de técnicas y casos de uso relacionados con el modus operandi de Big Data.

En el nivel más básico, el web scraping consiste en copiar datos de un sitio web. A continuación, los usuarios pueden importar los datos extraídos a una hoja de cálculo, una base de datos o un programa informático para procesarlos.

¿A quién beneficia el web scraping? Cualquiera que necesite amplios conocimientos sobre un tema concreto. Si alguna vez se ha aventurado en algún tipo de investigación, lo más probable es que su primer instinto haya sido copiar y pegar manualmente los datos de las fuentes en su base de datos local.

Hoy en día, los desarrolladores pueden utilizar fácilmente técnicas de web scraping gracias a las herramientas de automatización. Lo que antes llevaba semanas a un equipo, ahora puede hacerse de forma autónoma en cuestión de horas con total precisión.

Pasar del scraping manual al automatizado ahorra tiempo a los particulares. También supone una ventaja económica para los desarrolladores. Los datos recopilados mediante el uso de raspadores web pueden exportarse posteriormente a formato CSV, HTML, JSON o XML.

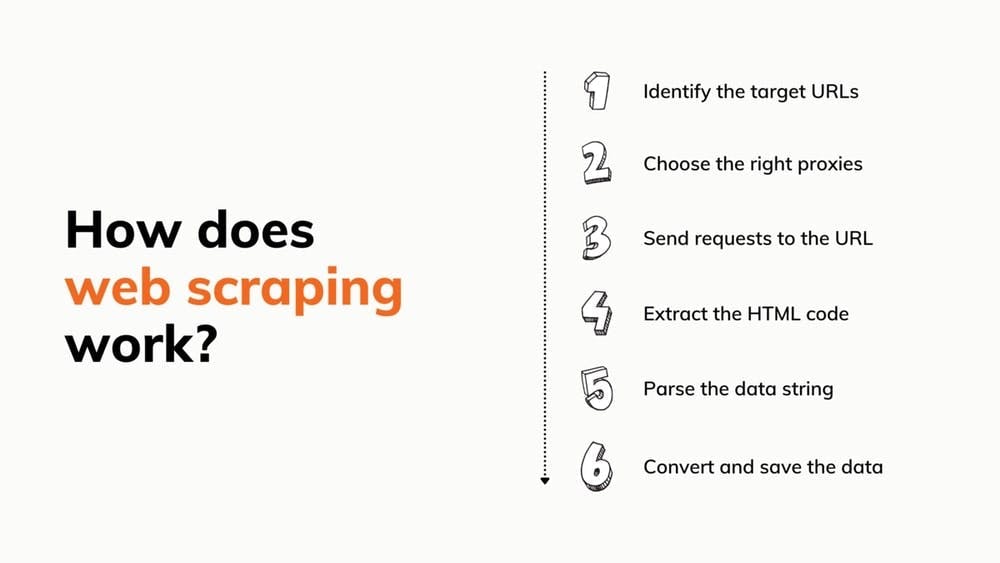

¿Cómo funciona el web scraping?

Suena fácil, ¿verdad? Bueno, construir un scraper desde 0 que pueda hacer todo eso lleva mucho tiempo. Por no mencionar que el bot puede no funcionar siempre y que necesitarás alquilar proxies. Sin embargo, si todavía quieres intentarlo, tenemos algunos tutoriales que te ayudarán.

Sin embargo, uno de los aspectos más atractivos de utilizar una herramienta prefabricada es lo sencillo que resulta incorporarla a tu proyecto. Todo lo que se necesita es un conjunto de credenciales y una comprensión rudimentaria de la documentación de la API.

Además, los rascadores prefabricados pueden venir con muchos otros extras:

- Un navegador headless incorporado para ejecutar javascript

- Un solucionador de Captcha

- Un grupo de proxy que abarca millones de IP

- Un rotador proxy

- Una interfaz sencilla para personalizar las solicitudes

Nuestro equipo ha desarrollado una API de web scraping que le ahorrará mucho tiempo investigando a fondo el sector y centrando nuestros esfuerzos en crear la solución más beneficiosa que se nos ocurrió.

¿Qué es el rastreo web?

Todos conocemos y utilizamos Google, Bing u otros motores de búsqueda. Utilizarlos es sencillo: les pides algo y ellos buscan en todos los rincones de la web para darte una respuesta. Pero, al fin y al cabo, Google prospera gracias a su rastreador Googlebot.

Los rastreadores web son utilizados por los motores de búsqueda para explorar Internet en busca de páginas de acuerdo con las palabras clave introducidas y recordarlas mediante indexación para su posterior uso en los resultados de búsqueda. Los rastreadores también ayudan a los motores de búsqueda a recopilar datos sobre los sitios web: URL, hipervínculos, metaetiquetas y contenido escrito, así como la inspección del texto HTML.

No tienes que preocuparte de que el bot se quede atascado en un bucle sin fin de visitas a los mismos sitios porque mantiene un registro de lo que ya ha accedido. Su comportamiento también está determinado por una mezcla de criterios como:

- política de nuevas visitas

- política de selección

- política de deduplicación

- política de cortesía

Los rastreadores web se enfrentan a varios obstáculos, entre ellos la inmensa y siempre cambiante Internet pública y la selección de contenidos. A diario se publican infinidad de informaciones. Por ello, tendrían que actualizar constantemente sus índices y cribar millones de páginas para obtener resultados precisos. No obstante, son partes esenciales de los sistemas que examinan el contenido de los sitios web.

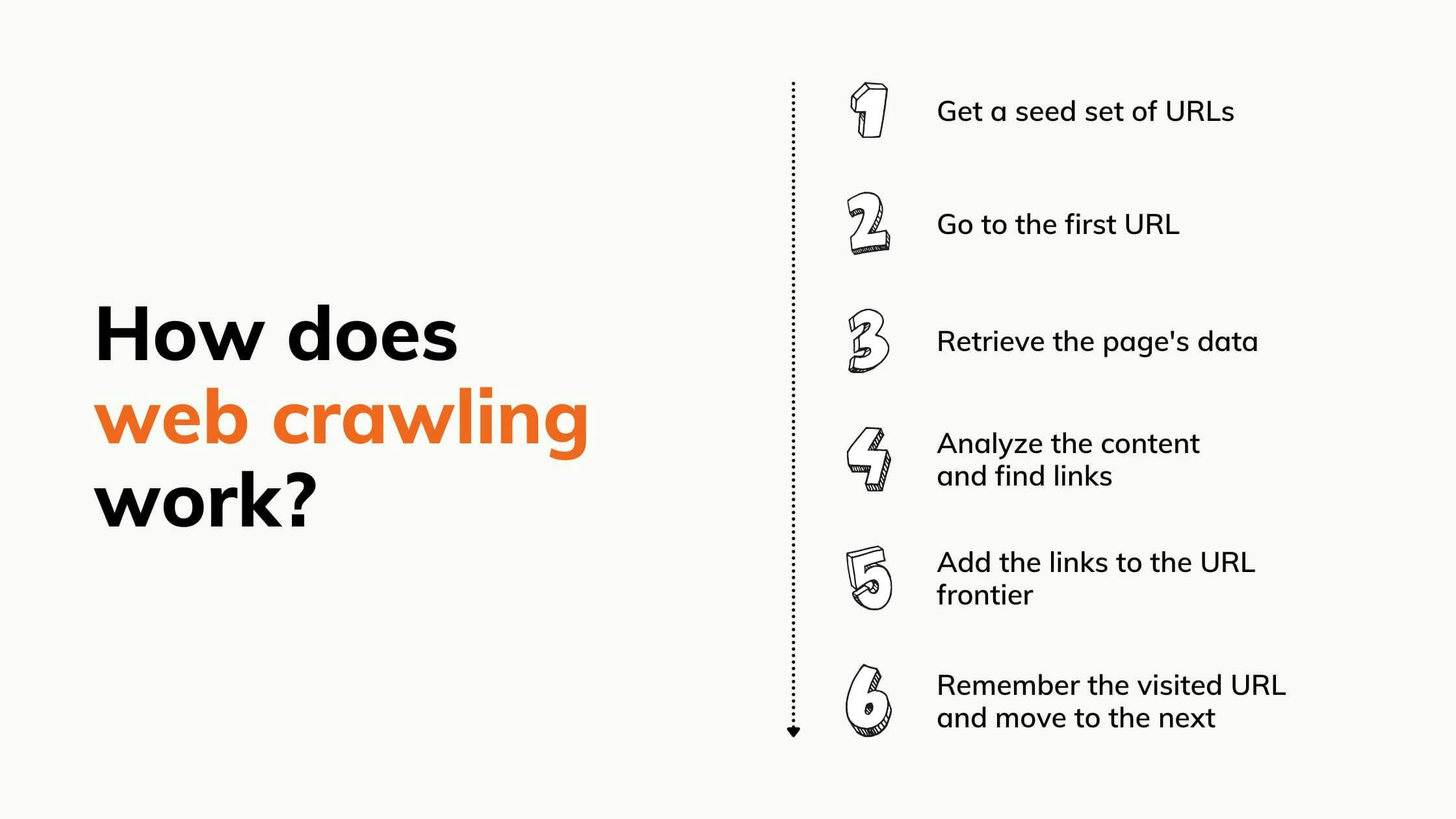

¿Cómo funciona el rastreo web?

Los motores de búsqueda no tienen forma de saber qué páginas web existen. Antes de que puedan obtener las páginas relevantes para las palabras clave, los robots deben rastrearlas e indexarlas. He aquí los 7 pasos exhaustivos:

Web Scraping vs. Web Crawling

El web scraping se confunde a menudo con el web crawling. El web scraping se diferencia del web crawling en que extrae y duplica datos de cualquier página a la que accede, mientras que el web crawling navega y lee páginas para indexarlas. El rastreo busca páginas y contenidos, el scraping se asegura de que los datos lleguen a usted.

El mito de que el web scraping y el web crawling funcionan simultáneamente es un malentendido en el que estamos dispuestos a mediar. El web scraping es una técnica de extracción de datos de páginas web. Ya se trate de páginas rastreadas, de todas las páginas de un sitio concreto o de páginas de archivos digitales, mientras que el rastreo web puede generar una lista de URL para que el scraper las recopile. Por ejemplo, cuando una empresa quiere recopilar información de un sitio, rastreará las páginas y luego raspará las que contengan datos valiosos.

Combinar el rastreo web y el scraping web permite una mayor automatización y menos complicaciones. Mediante el rastreo, puede elaborar una lista de enlaces y enviarla al scraper para que sepa qué extraer. El beneficio es la recopilación de datos de cualquier lugar de la World Wide Web sin ningún trabajo humano.

Casos prácticos

El web scraping y el web crawling forman una combinación extremadamente buena para recopilar y procesar rápidamente datos que un humano no sería capaz de analizar en el mismo plazo de tiempo. He aquí algunos ejemplos de cómo este tándem puede ayudar en los negocios:

Protección de la marca. Puede utilizar las herramientas para encontrar rápidamente contenidos en línea perjudiciales para su marca (como robo de patentes, infracción de marcas o falsificación) y enumerarlos para poder emprender acciones legales contra los responsables.

Seguimiento de marcas. La monitorización de marcas es mucho más sencilla cuando se utiliza un rastreador web. El rastreador puede descubrir menciones de su empresa en el entorno en línea y clasificarlas para que sean más fáciles de entender, como artículos de noticias o publicaciones en redes sociales. Añade web scraping para completar el proceso y obtener la información.

Control de precios. Las empresas utilizan el scraping para extraer datos de productos, analizar cómo afectan a su modelo de ventas y desarrollar la mejor estrategia de marketing y ventas. Los rastreadores, por su parte, buscarán nuevas páginas de productos que contengan información valiosa.

Marketing por correo electrónico. El web scraping puede recopilar sitios web, foros y secciones de comentarios a velocidades de vértigo y extraer todas las direcciones de correo electrónico que necesita para su próxima campaña. El rastreo de correo electrónico puede incluso buscar en foros y grupos de chat, comprobando si hay correos electrónicos ocultos pero que pueden encontrarse en las cabeceras.

Procesamiento del lenguaje natural. En este caso, los robots se utilizan para la investigación lingüística, en la que las máquinas ayudan a interpretar las lenguas naturales utilizadas por los humanos.

Los crawlers y scrapers se utilizan para proporcionar enormes volúmenes de datos lingüísticos a estas máquinas para que adquieran experiencia. Cuantos más datos se envíen a la máquina, más rápido alcanzará su nivel de comprensión ideal. Los foros, mercados y blogs en los que se publican diversos tipos de reseñas son los sitios más frecuentes para obtener este tipo de información.

Internet podrá entrenarlo para que, con el tiempo, capte y reconozca la jerga, algo crucial en el marketing actual y que busca atender a una gran variedad de orígenes.

Gestión de activos inmobiliarios: En el sector inmobiliario, los rastreadores web y los scrapers se utilizan a menudo por su capacidad para analizar datos y tendencias del mercado. Ambos proporcionan información detallada sobre propiedades o grupos específicos de edificios, independientemente de la clase de activo (oficinas, industrial o minorista), lo que ayuda a las empresas de arrendamiento a obtener una ventaja competitiva. Para poner las cosas en perspectiva, los bots generan información que permite mejorar las previsiones de mercado y las prácticas de gestión inmobiliaria.

Generación de clientes potenciales. Los anuncios y las ofertas especiales son inútiles si no llegan a las personas adecuadas. Las empresas utilizan rastreadores y scrapers para encontrar a esas personas, ya sea en las redes sociales o en los registros de empresas. Los robots pueden encontrar y recopilar rápidamente información de contacto que luego se enviará al equipo de ventas o marketing.

Cómo construir un rastreador web

Ahora que ya sabe cómo gira la rueda, probablemente se pregunte cómo rastrear sitios web. Construir tu propio rastreador ahorra dinero y es más fácil de lo que crees. Basándonos en ello, hemos preparado una guía detallada sobre los pros y los contras, los procedimientos y todo lo demás.

Requisitos previos

- Python3.

- IDE de Python. Recomendación/En esta guía, usaremos Visual Studio Code, pero cualquier otro IDE servirá.

- Selenium: para raspar el HTML de sitios web dinámicos.

- Beautifulsoup: para analizar el documento HTML.

- ChromeDriver: un controlador web para configurar selenium. ¡Descarga la versión correcta y recuerda la ruta donde lo guardaste!

Configurar el entorno

En primer lugar, vamos a instalar las librerías que necesitamos. Abre un terminal en el IDE de tu elección y ejecuta los siguientes comandos:

> pip install selenium

> pip install beautifulsoup4

Ahora vamos a importar las librerías que hemos instalado en nuestro código Python. También definimos la URL que vamos a rastrear y añadimos la configuración para selenium. Basta con crear un archivo crawler.py y añadir lo siguiente:

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from bs4 import BeautifulSoup

CHROMEDRIVER_PATH = "your/path/here/chromedriver_win32/chromedriver"

BASE_URL = "https://ecoroots.us"

SECTION = "/collections/home-kitchen"

FULL_START_URL = BASE_URL + SECTION

options = Options()

options.headless = True

driver = webdriver.Chrome(CHROMEDRIVER_PATH, options=options)

Elige un sitio web e inspecciona el HTML

Elegimos un sitio web de comercio electrónico que vende productos de residuo cero, y accederemos a la página de cada producto y extraeremos su HTML. Por lo tanto, buscaremos todos los enlaces internos del sitio web de la tienda y accederemos a ellos recursivamente. Pero antes, echemos un vistazo a la estructura de la página y asegurémonos de que no nos encontramos con ningún problema de rastreabilidad. Haz clic con el botón derecho del ratón en cualquier parte de la página, luego en Inspeccionar elemento y ¡voilá! El HTML es nuestro.

Construcción del crawler

Ahora podemos empezar a escribir el código. Para construir nuestro rastreador, seguiremos un flujo recursivo, de modo que accederemos a todos los enlaces que encontremos. Pero primero, vamos a definir nuestro punto de entrada:

def crawl(url, filename):

page_body = get_page_source(url, filename)

soup = BeautifulSoup(page_body, 'html.parser')

start_crawling(soup)

crawl(FULL_START_URL, 'ecoroots.txt')

Implementamos la función crawl, que extraerá los documentos HTML a través de nuestro procedimiento get_page_source. Luego construirá el objeto BeautifulSoup que nos facilitará el parseo y llamará a la función start_crawling , que comenzará a navegar por la web.

def get_page_source(url, filename):

driver.get(url)

soup = BeautifulSoup(driver.page_source, 'html.parser')

body = soup.find('body')

file_source = open(filename, mode='w', encoding='utf-8')

file_source.write(str(body))

file_source.close()

return str(body)

As stated earlier, the get_page_source function will use selenium to get the HTML content of the website and will write in a text file in the <body> section, as it’s the one containing all the internal links we are interested in.

unique_links = {}

def start_crawling(soup):

links = soup.find_all(lambda tag: is_internal_link(tag))

for link in links:

link_href = link.get('href')

if not link_href in unique_links.keys() or unique_links[link_href] == 0:

unique_links[link_href] = 0

link_url = BASE_URL + link_href

link_filename = link_href.replace(SECTION + '/products/', '') + '.txt'

crawl(link_url, link_filename)

unique_links[link_href] = 1Esta es la lógica principal del crawler. Una vez que recibe el objeto BeautifulSoup, extraerá todos los enlaces internos. Lo hacemos usando una función lambda, con algunas condiciones que definimos en la función is_internal_link:

def is_internal_link(tag):

if not tag.name == 'a': return False

if tag.get('href') is None: return False

if not tag.get('href').startswith(SECTION + '/products'): return False

return True

This means that for every HTML element that we encounter, we first verify if it’s a <a> tag, if it has an href attribute, and then if the href attribute’s value has an internal link.

Después de obtener el resumen de los enlaces, iteramos cada uno de ellos, construimos la URL completa y extraemos el nombre del producto. Con estos nuevos datos, tenemos un nuevo sitio web que pasamos a la función de rastreo desde nuestro punto de entrada, por lo que el proceso comienza de nuevo.

Pero, ¿y si nos encontramos con un enlace que ya hemos visitado? ¿Cómo evitamos un ciclo interminable? Bien, para esta situación, tenemos la estructura de datos unique_links. Para cada enlace que iteramos, verificamos si se ha accedido a él antes de empezar a rastrearlo. Si es nuevo, simplemente lo marcamos como visitado una vez finalizado el rastreo.

Una vez que ejecute el script, el rastreador comenzará a navegar por los productos del sitio web. Puede tardar unos minutos en función del tamaño del sitio web que elija. Por último, ahora debería tener un montón de archivos de texto que contendrán el HTML de cada página que visite su rastreador.

Reflexiones finales

El web crawling y el web scraping están muy interrelacionados e influyen mutuamente en su éxito al contribuir a la información que se procesa en última instancia. Esperamos que este artículo le ayude a evaluar el uso de estos mecanismos hermanos y los entornos en los que pueden emplearse.

La automatización es el futuro de la recopilación de datos. Sólo por eso, hemos ideado una solución que le ahorra la molestia de escribir código, con la que recibirá un acceso rápido a los contenidos web y evitará los bloqueos de IP. Antes de poner en orden su presupuesto, ¿por qué no echa un vistazo a nuestro paquete de prueba gratuito con proxies residenciales y móviles incluidos desde el primer momento? Sigue rascando.

Noticias y actualidad

Manténgase al día de las últimas guías y noticias sobre raspado web suscribiéndose a nuestro boletín.

Nos preocupamos por la protección de sus datos. Lea nuestra Política de privacidad.

Artículos relacionados

Descubra cómo extraer y organizar datos de forma eficaz para el raspado web y el análisis de datos mediante el análisis sintáctico de datos, las bibliotecas de análisis sintáctico HTML y los metadatos de schema.org.

Automatice el rastreo web y la descarga de archivos con Python y wget. Aprende a utilizar estas herramientas para recopilar datos y ahorrar tiempo.

Este tutorial mostrará cómo rastrear la web utilizando Python. El rastreo web es un potente método para recopilar datos de la web localizando todas las URL de uno o más dominios.