Guía de inicio rápido de la API de Web Scraping

Mihnea-Octavian Manolache el 14 Jul 2023

WebScrapingAPI ofrece un conjunto de soluciones de raspado web. Nuestro producto principal es un raspador web de uso general, diseñado para recopilar datos en tiempo real de cualquier sitio web. Como descubrirá a lo largo de esta guía, la herramienta está repleta de diversas funciones, lo que le permite pasar desapercibida para los sistemas anti-bot. Con un amplio conjunto de características, esta guía está diseñada para ayudarle a empezar a utilizar Web Scraping API. Estos son algunos de los detalles que cubriremos:

- Trabajar con el panel de control

- Comprender los parámetros y características de la API

- Envío de solicitudes básicas a la API

- Configuración de un raspador web complejo mediante los SDK

Por qué registrarse con Web Scraping API

Existen innumerables razones por las que debería utilizar Web Scraping API en lugar de un scraper normal. Sin embargo, nos basamos en los comentarios para decidir qué nos convierte en la mejor opción. Y aquí están algunas de las razones por las que nuestros clientes nos eligieron:

- Asistencia profesional - Nuestra asistencia está a cargo de ingenieros de software que trabajan con la API. Por lo tanto, cuando nos solicite ayuda, nos aseguraremos de que obtenga las mejores respuestas posibles. Además, si tiene algún problema, lo más probable es que el ingeniero que le atienda sea capaz de solucionarlo en muy poco tiempo y ponerlo en producción.

- Facilidad de uso: crear un raspador web puede ser todo un reto. Hay que tener en cuenta varios proxies, evasiones, captchas, navegadores, etc. Con Web Scraping API, se obtiene todo eso (y mucho más) con un "clic de un botón".

- Escalabilidad - Cuando creamos nuestro producto, una de nuestras primeras prioridades fue asegurarnos de ofrecer resultados independientemente del número total de solicitudes que recibiéramos. Cuando se suscribe a Web Scraping API, se suscribe a toda nuestra infraestructura. Y eso incluye proxies, navegadores, clientes HTTP y mucho más.

Suscripción gratuita a un rascador basado en la nube

Para registrarse en Web Scraping API, todo lo que se necesita es una dirección de correo electrónico válida. Además, cada usuario tiene derecho a una prueba gratuita de 7 días con acceso completo a las funciones de la API, limitada a 1000 créditos API. Después de estos 7 días, seguirá teniendo acceso a un nivel gratuito, que le ofrece 1000 créditos API al mes, pero con funciones API limitadas. Si desea seguir utilizando la versión completa de nuestro raspador web basado en la nube, le ofrecemos planes de precios flexibles. Puede consultar la página de precios para obtener información actualizada sobre los precios. En una nota alta, ofrecemos:

- un plan Starter, con hasta 100.000 créditos API y 20 llamadas simultáneas

- un plan Grow, con hasta 1.000.000 de créditos API y 50 llamadas simultáneas

- un plan Business, con hasta 3.000.000 de créditos API y 100 llamadas simultáneas

- un plan Pro, con hasta 10.000.000 de créditos API y 500 llamadas simultáneas

- un plan de empresa a medida que se debatirá en función de sus necesidades particulares

Para empezar, visite nuestra página SigUp aquí y cree una cuenta gratuita.

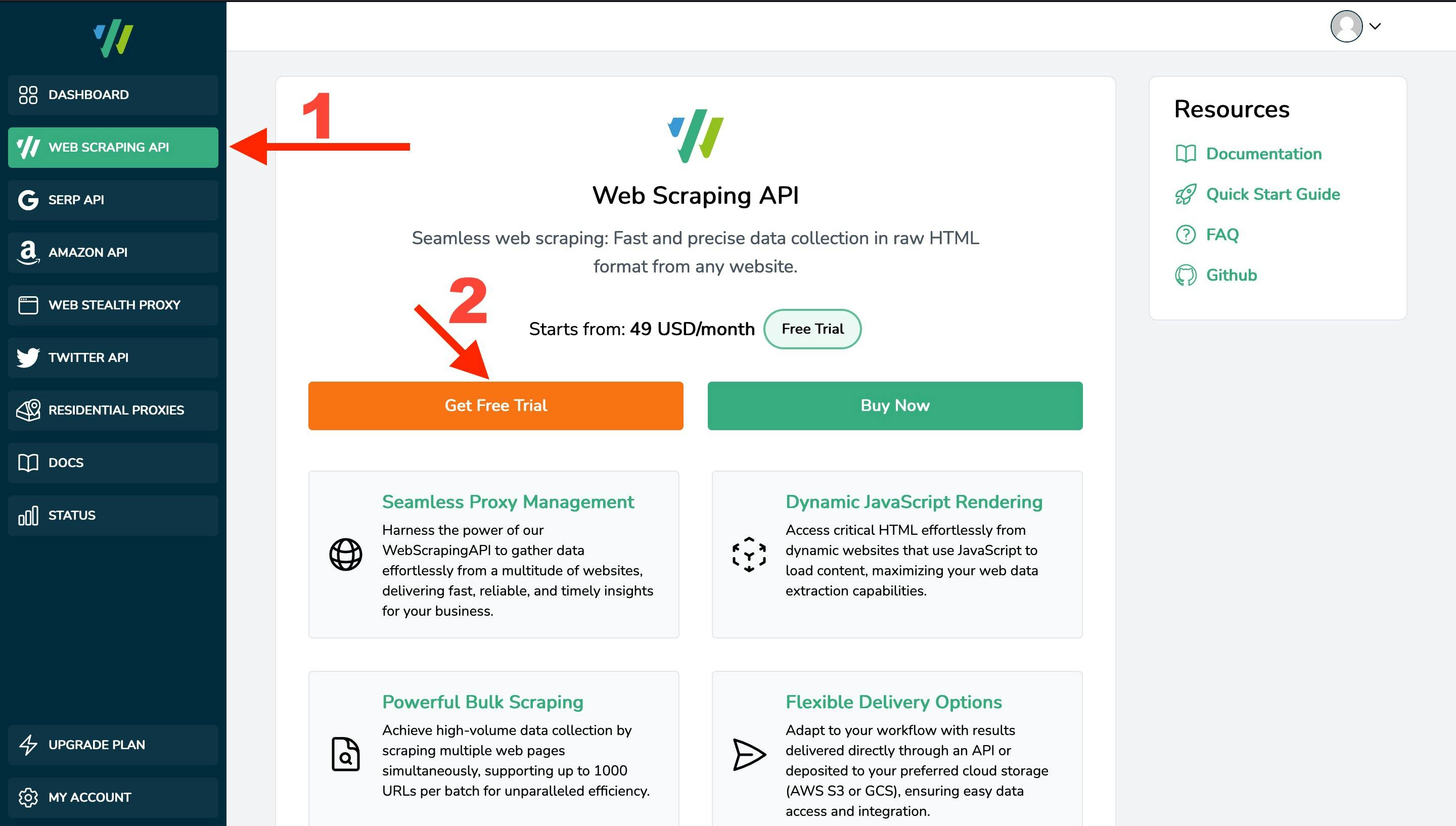

Entender el cuadro de mandos

Registrarse en nuestro Panel de control no le da acceso implícito a nuestros productos. Como verá, la barra lateral izquierda muestra algunas opciones asociadas a nuestros productos. Dado que esta guía se refiere al raspador web de uso general, para crear una suscripción a este servicio, navegue hasta Web Scraping API y haga clic en el botón "Obtener prueba gratuita". Una vez creada la suscripción, se le proporcionará una clave API. Asegúrese de guardarla bien, ya que será su identificador único en nuestros sistemas. A partir de ese momento, también podrá acceder a la página de estadísticas y al Playground.

Conceptos básicos de nuestra API Web Scraper

Hay tres maneras de interactuar con nuestro raspador web, dos de las cuales son digamos "programáticas" y una que es más "amigable para principiantes". Las dos primeras implican acceder a la API a través de clientes HTTP o a través de nuestros SDKs. La tercera es utilizando el Playground proporcionado dentro del Dashboard. Y llegaremos a ellos en breve, pero antes de eso, es importante entender cómo funciona la API. Sólo entonces serás capaz de utilizar toda la potencia de Web Scraping API. Así que empecemos por lo básico:

Autenticación de solicitudes

La forma en que autenticamos las solicitudes procedentes de usuarios registrados es habilitando el parámetro URL `api_key`. La clave de API única está vinculada a su cuenta y contiene información sobre permisos, uso, etc.

Tenga en cuenta que cada producto al que se suscriba tiene asociada una clave de API única. Por ejemplo, no puede utilizar la clave API de su raspador web de uso general en la API SERP o viceversa.

Dicho esto, para raspar una URL como usuario autenticado, deberá acceder al siguiente recurso:

https://api.webscrapingapi.com/v1?api_key=<YOUR_UNIQUE_API_KEY>

Parámetros API

Dentro de nuestra API, los parámetros de consulta se utilizan para personalizar el raspador en función de sus necesidades. Entender cómo funciona cada parámetro nos permitirá utilizar toda la potencia de nuestra API de web scraper. Mantenemos una documentación actualizada de los parámetros de la API aquí. Sin embargo, también vamos a sumergirnos en ellos aquí, para tener una mejor comprensión de cómo funcionan los parámetros de consulta con Web Scraping API. Dicho esto, hay tres tipos de parámetros: requeridos, por defecto y opcionales. Los requeridos son bastante simples:

- El parámetro `api_key` del que hemos hablado antes

- El parámetro `url`, que representa la URL que se desea raspar

Tenga en cuenta que el valor del parámetro `url` debe ser una URL válida, no un nombre de dominio, y lo ideal es que esté codificado como URL. (es decir, https%3A%2F%2Fwebscrapingapi.com)

En lo que respecta a los parámetros por defecto, hemos utilizado datos históricos para aumentar la tasa de éxito de nuestra API (e implícitamente la de su proyecto). Los datos internos muestran que la mejor configuración para el web scraping es utilizar un navegador web real emparejado con una dirección IP residencial. Por lo tanto, los parámetros por defecto de nuestra API son:

- `render_js=1`- para abrir un navegador real (no un cliente HTTP básico)

- `proxy_type=residential`- para acceder al objetivo a través de una dirección IP residencial (habilitado sólo si su plan actual soporta proxies residenciales)

Por supuesto, también puede sobrescribir el valor de estos parámetros, aunque no se lo recomendamos. El scraping con un cliente HTTP básico y proxies de centros de datos suele provocar que el sitio web objetivo detecte la actividad de scraping y bloquee el acceso.

A continuación, hablaremos de los parámetros opcionales. Dado que hemos documentado todos los parámetros en nuestra Documentación, por ahora sólo vamos a discutir los parámetros más utilizados:

- Parámetro: render_js

Descripción: Activando este parámetro, accederá a la URL de destino a través de un navegador real. Tiene la ventaja de renderizar archivos JavaScript. Es una gran opción para el scraping de sitios con mucho JavaScript (como los construidos con ReactJS, por ejemplo).

Documentación:[aquí] - Parámetro: proxy_type

Descripción: Se utiliza para acceder a la URL objetivo a través de una dirección IP residencial o de un centro de datos.

Documentación:[aquí] - Parámetro: stealth_mode

Descripción: El web scraping no es una actividad ilegal. Sin embargo, algunos sitios web tienden a bloquear el acceso a software automatizado (incluidos los raspadores web). Nuestro equipo ha diseñado un conjunto de herramientas que hace casi imposible que los sistemas anti-bot detecten nuestro raspador web. Puede activar estas funciones utilizando el parámetro stealth_mode=1.

Documentación:[aquí] - Parámetro: país

Descripción: Utilizado para acceder a su objetivo desde una geolocalización específica. Consulte los países compatibles [aquí].

Documentación:[aquí] - Parámetro: timeout

Descripción: Por defecto, terminamos una petición (y no cobramos si falla) después de 10s. Con ciertos objetivos, es posible que desee aumentar este valor hasta 60s.

Documentación:[aquí] - Parámetro: device

Descripción: Puedes usar esto para hacer que tu rascador parezca un 'desktop', 'tablet', o 'mobile'.

Documentación:[aquí] - Parámetro: wait_until

Descripción: En términos simples, una vez que alcanza la URL objetivo, congela el scraper hasta que ocurra un determinado evento. El concepto que seguimos se describe mejor [aquí].

Documentación:[aquí] - Parámetro: wait_for

Descripción: Este parámetro congela el scraper durante un tiempo especificado (que no puede exceder de 60s).

Documentación:[aquí] - Parámetro: wait_for_css

Descripción: Congela el scraper hasta que un determinado selector CSS (es decir, clase o ID) es visible en la página.

Documentación:[aquí] - Parámetro: session

Descripción: Permite utilizar el mismo proxy (dirección IP) en varias peticiones.

Documentación:[aquí]

Códigos de respuesta

Uno de los aspectos más importantes que tiene que saber sobre los códigos de respuesta es que sólo cobramos por las respuestas correctas. Por lo tanto, si su solicitud no obtiene el código de estado 200, no se le cobrará. Aparte de eso, los errores de la API están documentados aquí y, como verás, siguen los códigos de estado HTTP habituales. Por nombrar algunos:

- 400: Solicitud incorrecta - Cuando se envían parámetros no válidos, por ejemplo

- 401: No autorizado - Cuando no se envía una `api_key` o la clave API no es válida.

- 422: Entidad no procesable - Cuando la API no puede satisfacer la petición (como por ejemplo cuando el selector CSS que esperabas no está visible en la página).

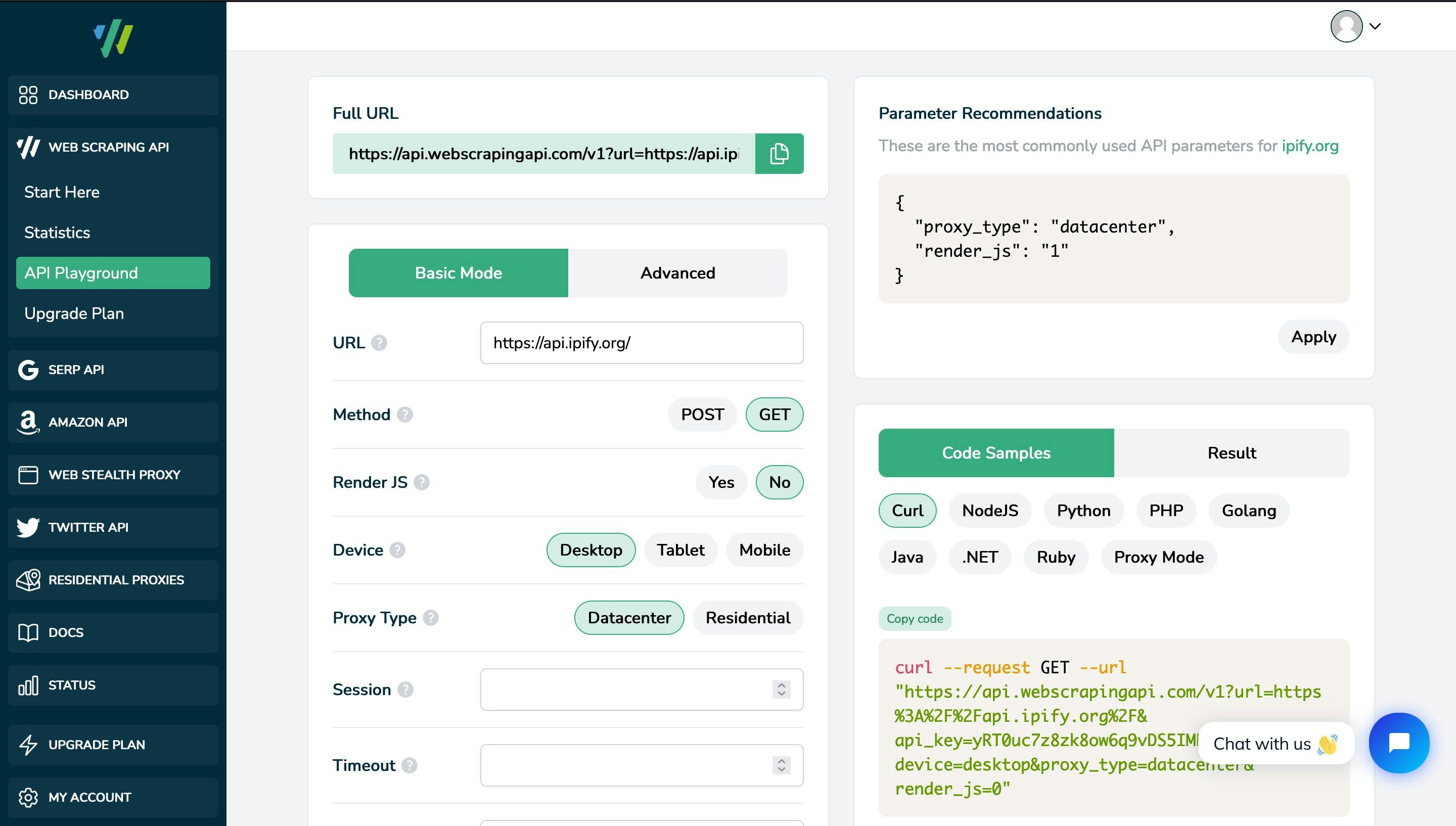

Interacción con la API Web Scraper

Como se ha dicho, hay principalmente tres formas de interactuar con la API de web scraper. En primer lugar, el uso de los SDK o el acceso a la API a través de clientes HTTP depende más del idioma (o de la tecnología) y requiere ciertos conocimientos técnicos. Una interfaz más amigable para principiantes está disponible en nuestro Dashboard, bajo el API Playground. Esta herramienta le permitirá jugar con nuestro raspador web, probarlo y comprender cómo utilizar los parámetros en su beneficio, antes de entrar en implementaciones programáticas o funciones avanzadas. Algunos aspectos clave de la zona de juegos son:

- Corrige automáticamente las incompatibilidades de los parámetros (por ejemplo, `stealth_mode=1` es incompatible con `render_js=0`).

- Proporciona ejemplos de código reales para varios lenguajes de programación que puede utilizar en su proyecto.

- Muestra los parámetros recomendados, basados en nuestras pruebas internas y en datos históricos de solicitudes anteriores, para que pueda aumentar la tasa de éxito de su proyecto.

Funciones avanzadas de Web Scraping

Para usuarios avanzados, nuestra API está repleta de diversas funciones que la hacen personalizable y preparada para cualquier proyecto de scraping. Una vez más, una buena fuente de información es nuestra documentación oficial. Sin embargo, aquí hay algunos de los aspectos que debemos destacar:

POST, PUT y PATCH

Con la API de web scraping, no está obligado a utilizar únicamente solicitudes GET. Si su proyecto de scraping necesita crear, sustituir o actualizar recursos, puede utilizar nuestras solicitudes POST, PUT o PATCH. Un aspecto clave de estas solicitudes es que también puede utilizar `render_js=1`, lo que significa un navegador web real, no un simple cliente HTTP. Un ejemplo de petición POST es:

curl --request POST --url "https://api.webscrapingapi.com/v1?api_key=<YOUR_API_KEY>&url=https%3A%2F%2Fhttpbin.org%2Fpost" --data "{

"foo": "bar"

}"Modo proxy

También puede utilizar nuestra API como proxy para rastrear su URL objetivo. Para acceder a la API como proxy, debe tener en cuenta lo siguiente:

- El nombre de usuario para autenticarse con el proxy es siempre `webscrapingapi`, seguido de los parámetros que desea habilitar, separados por puntos.

- La contraseña es siempre su clave personal de API

Aquí tienes un ejemplo de url que puedes utilizar para acceder al raspador web a través de nuestro Modo Proxy:

https://webscrapingapi.<parameter_1.parameter_2.parameter_n>:<YOUR_API_KEY>@proxy.webscrapingapi.com:8000

Conclusiones

Web Scraping API ofrece un conjunto de potentes herramientas de scraping respaldadas por un equipo de ingenieros y listas para usar. Está repleto de docenas de funciones que lo convierten en una solución de raspado web personalizable. Además, puede integrar el raspador web en la nube de uso general con cualquier lenguaje de programación o tecnología, ya que devuelve HTML sin procesar o JSON analizado. Además, nuestra extensa documentación y repositorios públicos de GitHub deberían ayudarte a empezar con tu proyecto en muy poco tiempo.

Esperamos que esta guía sea un buen punto de partida para usted y, por favor, tenga en cuenta que nuestro soporte está siempre a su disposición si tiene alguna pregunta. ¡Esperamos ser su socio en el éxito!

Noticias y actualidad

Manténgase al día de las últimas guías y noticias sobre raspado web suscribiéndose a nuestro boletín.

Nos preocupamos por la protección de sus datos. Lea nuestra Política de privacidad.

Artículos relacionados

Raspe Amazon de forma eficiente con la solución rentable de Web Scraping API. Acceda a datos en tiempo real, desde productos hasta perfiles de vendedores. ¡Inscríbase ahora!

Recopile sin esfuerzo datos en tiempo real de los motores de búsqueda mediante la API SERP Scraping. Mejore el análisis de mercado, el SEO y la investigación temática con facilidad. ¡Empiece hoy mismo!

Explore el poder transformador del web scraping en el sector financiero. Desde datos de productos hasta análisis de opiniones, esta guía ofrece información sobre los distintos tipos de datos web disponibles para tomar decisiones de inversión.