Rotación de proxies: Todo lo que necesita saber

Raluca Penciuc el 08 Ene 2023

Cuando empezaste a aprender los fundamentos del web scraping, ¿tuviste un momento de "oh maldición, necesitaré proxies para esto"? Bueno, prepárate para tener ese tipo de epifanía de nuevo, porque los proxies rotativos son el siguiente nivel en la funcionalidad de raspado web.

¿No me cree? Veamos las ventajas que aportan los proxies si no los rotas y luego las ventajas extra que obtienes con la rotación. Esto es lo que aportan las IPs que no rotan:

- Puedes reintentar el scraping de una página/sitio web después de que la IP inicial sea bloqueada.

- Puedes cambiar manualmente de dirección para evitar los sitios web que utilizan la geolocalización para restringir contenidos.

- No revelas tu ubicación real.

- Añadiendo un retardo a la solicitud, puede extraer datos de sitios web con contramedidas anti-scraping.

No cabe duda de que es bueno tener estas cosas, pero veamos qué ocurre cuando se les da un nuevo giro (valga el juego de palabras):

- El scraper envía continuamente peticiones hasta que consigue obtener la información que necesita.

- Puedes acceder fácilmente a contenidos con restricciones geográficas desde cualquier país en el que tengas un proxy.

- Los sitios web ni siquiera saben que son visitados por bots.

- Puede obtener datos de cualquier sitio web sin tener que ralentizar las peticiones.

Esto es sólo un breve resumen de las diferencias, pero es bastante impresionante, ¿no? Así que vamos a ver cómo se consiguen estas ventajas.

¿Qué son los proxies rotatorios?

Por rotación de proxies, nos referimos al proceso de cambiar automáticamente de una IP a otra con cada petición enviada. En teoría, esto puede hacerse manualmente, pero significaría que no podrías poner en cola una lista de URLs para el scraping. En su lugar, tendrías que asignar un proxy, enviar una petición, asignar otro proxy, enviar otra petición, y así sucesivamente. Espero que veas lo ineficiente que sería.

Para la rotación automática de proxy, necesitarás un nuevo intermediario, un proxy a tu proxy, por así decirlo. Este nuevo intermediario es un servidor que tiene acceso a todo tu grupo de proxies. Así, en lugar de que tú busques en la lista de IPs, el servidor lo hace por ti. Todo lo que tienes que hacer es darle la orden.

A continuación se muestra el proceso de raspado con un programa que rota los proxies:

- El usuario envía una solicitud al servidor de gestión proxy.

- El servidor elige un proxy al azar (a menos que se especifique lo contrario) y le envía la solicitud.

- A continuación, el proxy envía la solicitud al objetivo final, la página web con los datos a extraer.

- La respuesta toma la misma ruta de vuelta al usuario.

Estos cuatro pasos se repiten hasta que el usuario dispone de toda la información que desea. Cada solicitud pasa por un nuevo proxy, simulando las acciones de muchos usuarios diferentes que se conectan a un sitio web.

Así que, en esencia, los proxies rotatorios no requieren ningún trabajo extra por tu parte. Eso es lo bueno. Es más automatización para una herramienta que ya está pensada para recopilar toneladas de información sin esfuerzo por parte del usuario.

Por supuesto, para la rotación de IP, necesitas ante todo un grupo de proxies. Sin embargo, como no todos los proxies son iguales, también necesitas reunir las IPs adecuadas. Aquí están los dos principales contendientes:

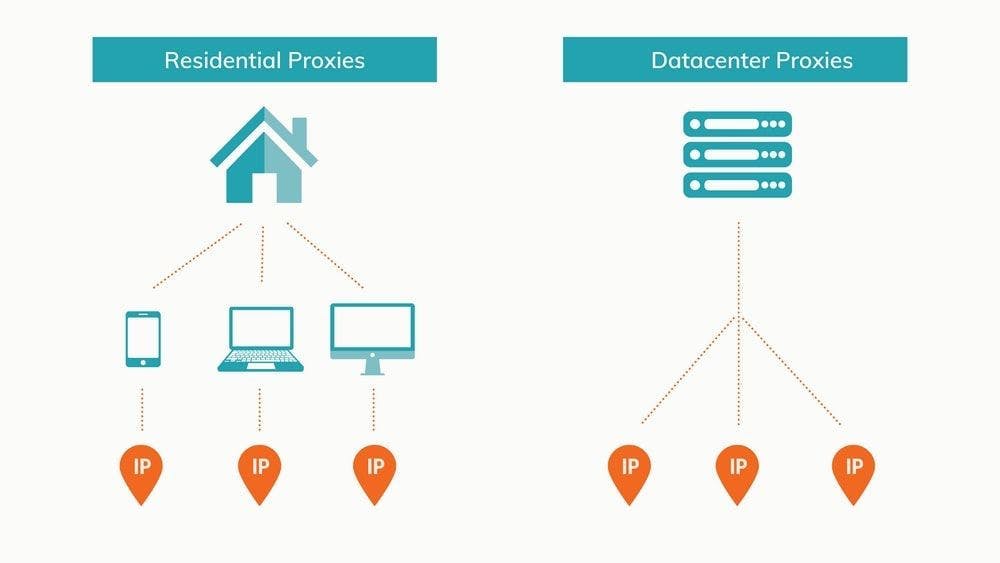

Centro de datos frente a residencial

Hay varias formas de clasificar los proxies. Se puede optar por el anonimato, el acceso o el origen. Este último factor es el más importante para los proyectos de web scraping. En ese sentido, los proxies suelen ser de centro de datos o residenciales. Veamos cada uno de ellos.

Centros de datos proxy rotatorios

Los centros de datos se llaman así por su incomparable capacidad para almacenar y compartir información en línea. El término "almacenado en la nube" es sólo una forma más concisa de decir "almacenado en un centro de datos, y puedes acceder a él siempre que tengas Internet". La versión más corta rueda mucho mejor por la lengua.

Los centros de datos son, en esencia, enormes colecciones de servidores interconectados con una colosal capacidad combinada de almacenamiento y la infraestructura necesaria para mantenerlos en funcionamiento. Los proxies de los centros de datos, como habrás adivinado, se alojan en estas estructuras. Para obtener proxies, hay que crear un servidor virtual, instalar en él un sistema operativo y, a continuación, instalar un software especializado para configurar IPs como proxies.

La clave de un centro de datos proxy eficiente es encontrar el equilibrio adecuado entre servidores e IP. Un servidor puede albergar varias IP, pero cada una genera más sobrecarga. En algún momento, obtendrás rendimientos decrecientes del servidor y tendrás que hacer uno nuevo. Hacer malabarismos con los servidores y las IP es mucho trabajo, así que la mayoría de los desarrolladores prefieren alquilar o comprar estos proxies a empresas especializadas.

Las IP no están asociadas a un proveedor de servicios de Internet. En su lugar, estás tratando con los propietarios del centro de datos o con un tercero que utiliza el espacio de almacenamiento para configurar proxies y distribuirlos a los clientes.

Son una opción popular para los raspadores web porque:

- Son baratas en comparación con las IP residenciales debido a la forma en que se configuran en masa;

- Su velocidad superior le permite recopilar más datos en menos tiempo;

- Son muy fiables gracias a la sólida infraestructura de los centros de datos;

- Es fácil comprar o alquilar en grandes cantidades desde la misma granja de servidores.

Por supuesto, todo tiene sus inconvenientes. Para los proxies de centros de datos, esos son:

- Sus IP son más fáciles de detectar por los sitios web vigilantes;

- Todos los proxies del mismo centro de datos comparten un identificador de subred, lo que los hace más propensos a las prohibiciones generales.

- Es más difícil crear un grupo de proxy con IP de todos los países, ya que hay pocos centros de datos.

Mediante el uso de proxies de centros de datos rotatorios, se puede acceder con éxito y raspar la mayoría de los sitios web. Dado que cada nueva solicitud procede de una IP diferente, es relativamente difícil rastrear y bloquear el scraper.

Los sitios web avanzados y populares son otra historia. Amazon, Google y otros nombres importantes se enfrentan a diario a scrapers y otros bots. Como resultado, es mucho más probable que se den cuenta. Además, los proxies de centros de datos siempre corren el riesgo de ser baneados ya que todas las IPs del mismo centro de datos comparten una subred.

Lo que más importa es a quién elijas como proveedor de servicios proxy y cómo gestionan sus IPs. Por ejemplo, los proxies de los centros de datos de WebScrapingAPI son privados y garantizan la ausencia de listas negras.

Rotación de apoderados residenciales

Si los centros de datos son la alternativa nueva y de alta tecnología, las IP residenciales son la opción probada y verdadera. Las IPs residenciales son dispositivos reales conectados a la web a través de un ISP. Estos proxies son prácticamente indistinguibles de los usuarios normales porque, en cierto sentido, no son más que eso.

Configurar un grupo de proxy de centro de datos requiere algunos conocimientos de CS, dinero y el software adecuado. Por otro lado, reunir IPs residenciales es mucho más complicado. En primer lugar, tendrías que convencer a la gente para que te dejara instalar un software especializado en su dispositivo que te diera acceso desde lejos. Luego, tendrían que dejar siempre las máquinas encendidas. De lo contrario, el proxy a veces sería inutilizable.

Debido a los inconvenientes y al grado de confianza necesario, es sumamente fácil para los desarrolladores alquilar proxies residenciales a proveedores de servicios dedicados.

En comparación con los proxies de los centros de datos, las IP residenciales tienen algunas ventajas clave:

- Las IP residenciales están respaldadas por los ISP y parecen visitantes normales mientras navegan por la web, lo que hace que el scraper sea más difícil de detectar;

- Cada IP es única, por lo que incluso si un proxy es identificado y bloqueado, todos los demás siguen siendo utilizables;

- Es más fácil preparar un grupo de proxies desde una amplia gama de ubicaciones, lo que garantiza un acceso más fácil a contenidos con restricciones geográficas.

A pesar de estas ventajas sustanciales que hacen de los proxies residenciales lo mejor de lo mejor en términos de eficacia, también tienen algunos inconvenientes:

- Suelen tener un coste más elevado;

- Debido a la ubicación y a la conexión a Internet del dispositivo, la velocidad de las solicitudes varía de una IP a otra y suelen ser más lentas que los proxies de los centros de datos;

- Tienes que elegir cuidadosamente un proveedor de proxies residenciales, asegurándote de que ofrecen un buen número de IPs y de que tienen proxies en los países que necesitas para tu proyecto.

Los proxies residenciales combinados con un sistema de rotación de IP y un script que cicla las cabeceras de las peticiones (especialmente el usuario-agente) proporcionan la mejor cobertura. Con ellos, tu web scraper puede recopilar datos sin toparse con barreras, como bloqueos de IP o CAPTCHAs.

Debido a su autenticidad, los proxies residenciales suelen utilizarse para el scraping de sitios web más complejos, como motores de búsqueda, grandes sitios de comercio electrónico o plataformas de redes sociales. Sin embargo, si inicias sesión en estos sitios, desactiva la rotación de proxies para que todas las solicitudes procedan de la misma IP. De lo contrario, parecerá que el mismo usuario está enviando peticiones desde todo el mundo en cuestión de segundos, demostrando que se trata de un bot.

Por qué utilizar proxies rotatorios para el web scraping

Algunos sitios web tienden a ser objetivos populares para los web scrapers. Me vienen a la mente Google, Amazon y Facebook. Estas plataformas esperan bots, por lo que implementan métodos tanto para ralentizarlos como para detenerlos. Con el aumento de popularidad que están experimentando los web scrapers, cada vez son más los sitios web que utilizan estas contramedidas.

En este contexto, cada vez es más importante que rotes tus IP. De lo contrario, corres el riesgo de encontrarte con constantes bloqueos de IP, captchas y que tu pool de proxys se vuelva poco a poco ineficaz.

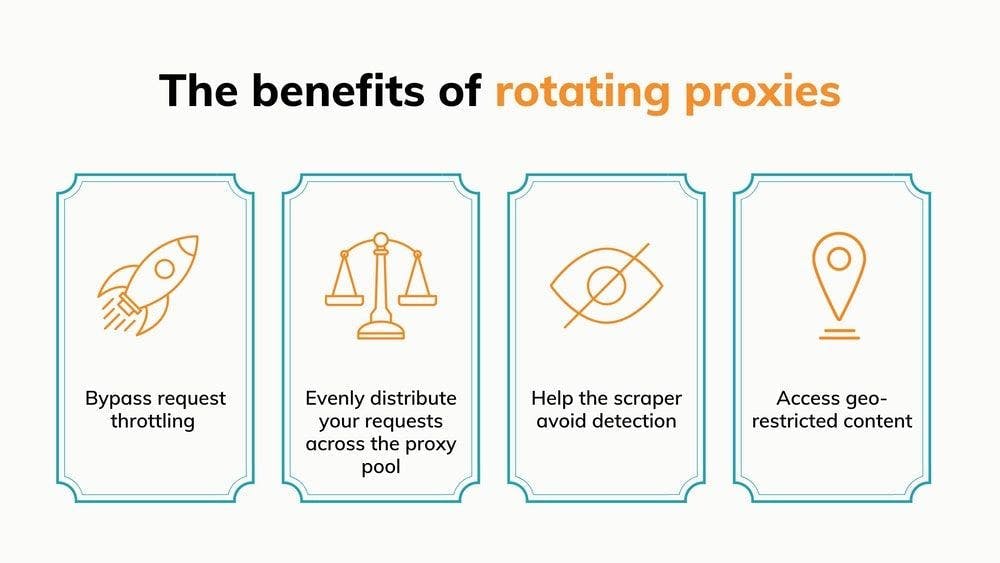

Evitar el estrangulamiento de solicitudes

El estrangulamiento de peticiones es una técnica mediante la cual los sitios web disminuyen la velocidad a la que pueden navegar los robots. En pocas palabras, limita el número de peticiones que un visitante puede hacer en un tiempo determinado.

Una vez alcanzado el límite, el bot es redirigido a una página CAPTCHA. Si su herramienta de raspado web no tiene capacidad para resolver CAPTCHA o no funciona, la IP no puede seguir raspando en ese sitio web.

La clave es que los sitios web controlan el número de solicitudes enviadas desde cada IP. Si sus peticiones se envían desde varias direcciones, la carga se reparte entre ellas. He aquí un ejemplo:

Si un sitio web está configurado para que, después de 10 solicitudes, la undécima active un CAPTCHA, eso significa que puedes raspar 10 páginas antes de tener que parar y cambiar manualmente la IP. Si estás recopilando información sobre precios, eso puede ser una gota de agua en el vaso comparado con el número total de páginas que quieres escrapear.

Al rotar tus proxies, eliminas la necesidad de intervenir manualmente. Podrás rotar diez veces el número de proxies que tengas. Entonces, el único límite es el tamaño del grupo de proxies, cada IP se utiliza en todo su potencial.

Lo mejor es que el estrangulamiento de peticiones limita el número de visitas durante un periodo determinado. Con un grupo de proxies lo suficientemente grande, el temporizador de los proxies que ya hayas utilizado expirará antes de que tengas que volver a recurrir a ellos, lo que te proporcionará una capacidad de scraping prácticamente ilimitada.

Distribución uniforme de las solicitudes en el conjunto de proxy

Por la misma lógica que el punto anterior, la rotación de proxies garantiza que no estás utilizando en exceso las mismas IPs mientras otras permanecen inactivas. En términos básicos, estás utilizando tus recursos de la forma más eficiente posible. El resultado - puedes obtener los mismos resultados con un menor número de IPs.

Sin rotación de proxies, usas la misma IP hasta que se bloquea mientras los demás proxies acumulan polvo. Cuando uno deja de funcionar, pasas al siguiente. Este método hace que los proxies parezcan un recurso finito que se agota para recopilar datos. Eso no es necesario.

Con una buena distribución de ubicaciones y centros de datos/residencias, un grupo de proxies decente puede durar indefinidamente si se rotan las IPs. Todo lo que necesitas es asegurarte de que ningún proxy sobresalga y corra el riesgo de ser bloqueado.

En la misma línea, la rotación de proxy puede acelerar exponencialmente el proceso de scraping. La clave aquí son las peticiones concurrentes. La mayoría de las API de raspado web pueden enviar varias solicitudes simultáneamente, cuyo número depende del paquete que elijas.

Enviar 50 solicitudes al mismo tiempo a un mismo sitio web es una señal de alarma. De hecho, se aleja tanto del comportamiento normal de los usuarios que lo más probable es que te bloqueen inmediatamente. Seguro que ya te imaginas por dónde va esto. Rotar tus proxies es una necesidad, ya que te permite llevar el scraper a sus límites sin ser bloqueado.

Ayuda al rascador a evitar ser detectado

Hablando de ser bloqueado, una de las ventajas más significativas de los proxies rotatorios es el anonimato que garantizan. Profundicemos en ello.

A los sitios web no les gusta demasiado que los visiten robots. Puede que estén intentando impedir que recopilen datos o simplemente tratando de asegurarse de que ningún programa malicioso intenta colapsar sus servidores. Por eso implementan varias contramedidas para detectar y bloquear bots. Como los web scrapers navegan por Internet más rápido que los usuarios normales, destacan. Pensemos en el ejemplo de las 50 solicitudes simultáneas. Según ContentSquare's 2020 Digital Experience Benchmark, el usuario medio pasa 62 segundos en una sola página. La diferencia de comportamiento es evidente.

Con los proxies rotatorios, usted cambia constantemente de IP y evita enviar numerosas peticiones desde una única dirección. El resultado: el sitio web ve el tráfico que generas como un grupo de visitantes separados sin conexión entre ellos.

Acceder a contenidos con restricciones geográficas

Un rotador de proxies no debería limitarse a cambiar de IP al azar. Claro, a veces eso es suficiente, pero una funcionalidad más avanzada que deberías buscar es la opción de rotar proxies de una región específica.

Esta característica es fundamental cuando se trata de recopilar información relativa a una sola región. Dependiendo del origen geográfico de una solicitud, algunos sitios web pueden:

- Mostrar datos específicos del origen de la IP

- Restringir el acceso porque la solicitud procede de un país bloqueado

Por tanto, al rotar un grupo de proxy diverso, puede mitigar los inconvenientes y aprovechar las ventajas. Aplicado a los puntos anteriores, eso significa:

- Obtenga una mejor visión general de los mercados extranjeros obteniendo datos específicos de varios países;

- Extraer información que de otro modo sería inaccesible debido a que determinados países tienen bloqueado el acceso al sitio web.

Es importante estar alerta y darse cuenta de cuándo los sitios web personalizan su contenido en función del origen de la solicitud. Estos sitios tienen el potencial de ofrecer grandes perspectivas sobre los datos de un país. Aun así, si no sabes que estás recibiendo información personalizada, puedes acabar con inexactitudes significativas en tus datos.

Cómo utilizar proxies rotatorios

Al igual que los raspadores web, puedes construir, gestionar y utilizar un rotador de proxies por tu cuenta. Para ello, necesitarás conocimientos de programación (Python es ideal, ya que tiene muchos frameworks valiosos y una comunidad activa), algunos conocimientos generales de informática, una lista de proxies y mucha paciencia.

La forma más básica sería un script que recibe una variable que contiene tu lista de proxy y asigna IPs aleatorias para cada petición. Por ejemplo, podrías usar la función random.sample() para elegir una IP completamente al azar cada vez, pero eso significa que el mismo proxy podría ser usado varias veces consecutivas. En ese caso, podrías hacer que después de que una IP sea usada, sea sacada de la lista de proxy, para que no sea usada de nuevo hasta que todas las otras direcciones sean usadas también.

He aquí un breve ejemplo en Python:

import random

import requests

proxy_pool = ["191.5.0.79:53281", "202.166.202.29:58794", "51.210.106.217:443", "5103.240.161.109:6666"]

URL = 'https://httpbin.org/get'

while len(proxy_pool) >0:

random_proxy_list = random.sample(proxy_pool, k=1)

random_proxy = {

'http': 'http://' + random_proxy_list[0],

}

response = requests.get(URL, proxies=random_proxy)

print(response.json())

proxy_pool.remove(random_proxy_list[0])

El código sólo cicla el proxy una vez y lo hace para una única URL, pero debería ilustrar bien la lógica. Tomé las IPs de https://free-proxy-list.net/, por cierto. Como era de esperar, no funcionaron.

De hecho, ese es el problema de construir tu propio rotador. Seguirás necesitando buenas IPs dedicadas o al menos compartidas. Una vez que estés en el punto de comprar proxies, también podrías buscar una solución que rote las IPs por ti. De esta manera, no gastas tiempo extra construyéndolo o dinero extra subcontratándolo. Además, obtienes más ventajas como:

- Una opción rápida para rotar sólo las IPs de una región específica;

- Posibilidad de elegir el tipo de proxy que se va a utilizar (centro de datos o residencial, normal o móvil, etc.).

- Configurar IPs estáticas para cuando estés haciendo scraping detrás de una pantalla de login;

- Reintentos automáticos con IPs nuevas cuando falla una solicitud.

Tomemos WebScrapingAPI como ejemplo de lo fácil que es raspar una página con proxies rotatorios. El siguiente código está sacado directamente de la documentación, donde hay muchos otros fragmentos como este:

import requests

url = "https://api.webscrapingapi.com/v1"

params = {

"api_key":"XXXXXX",

"url":"https://httpbin.org/get",

"proxy_type":"datacenter",

"country":"us"

}

response = requests.request("GET", url, params=params)

print(response.text)

Este es todo el código que necesitas para scrapear una URL mientras usas proxies de centros de datos de EEUU. Ten en cuenta que no hay una lista de IPs que rotar o incluso un parámetro para ello. Eso es porque la API cambia los proxies por defecto. Si quieres usar la misma IP para múltiples sesiones, simplemente añade un nuevo parámetro:

import requests

url = "https://api.webscrapingapi.com/v1"

params = {

"api_key":"XXXXXX",

"url":"https://httpbin.org/get",

"proxy_type":"datacenter",

"country":"us",

"session":"100"

}

response = requests.request("GET", url, params=params)

print(response.text)

Basta con utilizar el mismo número entero para el parámetro "sesión" para utilizar la misma IP estática para cualquier URL.

Los mejores proveedores de proxy rotatorio

Ahora que ya sabes cómo los proxies rotatorios pueden optimizar el proceso de web scraping, el siguiente paso debería ser elegir un proveedor de proxies que se ajuste a tus necesidades y recursos. He recopilado una lista de mis favoritos basándome en varios factores diferentes: precios, ubicaciones de los proxies y número de proxies de centros de datos y residenciales.

1. WebScrapingAPI

Déjeme preguntarle: ¿qué hay mejor que conseguir proxies rápidos, eficaces y asequibles para conectarse a su raspador web?

La respuesta: conseguir una API de web scraping rápida, eficiente y asequible que lo haga todo por usted. Podría seguir y seguir sobre las funcionalidades de extracción de datos de WebScrapingAPI, pero centrémonos en las IPs por ahora. El conjunto total de proxy tiene más de 100 millones de IPs repartidas por todo el mundo.

En lugar de medir el uso del ancho de banda, puedes elegir un paquete con un número determinado de llamadas a la API. Cada llamada a la API significa una página raspada, cada una a través de una IP diferente ya que, como he mencionado, la rotación de proxy está activada por defecto.

Hay cinco paquetes entre los que elegir, incluida una opción gratuita que te ofrece 1.000 llamadas API al mes (además de la prueba gratuita) para que te formes una opinión sobre el producto. El precio empieza en 20 dólares por 200.000 llamadas a la API, y las tarifas mejoran con los paquetes más grandes. Para casos de uso especiales, podemos trabajar en la adaptación de un plan personalizado que satisfaga sus necesidades.

Si quieres extraer datos a través de proxies desde una ubicación específica, tienes bastantes opciones. El conjunto de proxies del centro de datos se divide entre 7 países, mientras que las IP residenciales se pueden elegir entre 40 zonas diferentes. Si eso no es suficiente, puede optar por un paquete personalizado con la opción de añadir otras 195 ubicaciones a su lista.

2. Oxylabs

Oxylabs adoptó un enfoque interesante con la rotación de IP. Normalmente, cuando eliges un paquete, tienes que rotar las IPs por tu cuenta, pero tienes la opción de comprar también su rotador de proxy como complemento.

Aunque algunos casos de uso pueden no depender mucho de la rotación de proxies, es imprescindible en la extracción de datos, así que si eliges proxies Oxylabs, consigue también el rotador.

La empresa ofrece paquetes separados para proxies residenciales y de centros de datos. El uso residencial de IP tiene un precio basado en el ancho de banda utilizado, con el plan más bajo a partir de 300 dólares al mes por 20 GB de tráfico. Los proxies para centros de datos tienen un ancho de banda ilimitado, y los paquetes difieren en el número de IPs que se obtienen. Estos empiezan en 160 dólares al mes, y tienes que elegir entre 100 IPs de EE.UU. o 60 IPs no estadounidenses.

En total, tienen más de 100 millones de proxies residenciales y 2 millones de proxies de centros de datos. Así que es poco probable que te quedes sin IP.

El conjunto de proxies se extiende por un área impresionante: 186 ubicaciones diferentes. Aunque todos esos países tienen IPs residenciales, no esperes que todos ellos tengan también proxies de centros de datos.

3. Cambiador

Shifter aprovecha al máximo la infraestructura de vanguardia que hay detrás de los proxies de centros de datos. Como resultado, también ofrecen proxies de centro de datos compartidos además de la opción de IP dedicada que esperas.

Algo que nos gusta de la oferta de Shifter es el gran número de paquetes para elegir. Por ejemplo, el plan de proxy compartido más pequeño empieza en 30 dólares al mes para acceder a 10 proxies compartidos. En el otro extremo del espectro, puedes conseguir 1.000 proxies compartidos por 2.000 dólares. En resumen, tienes opciones.

Los proxies de centros de datos dedicados son previsiblemente más caros, con el paquete más barato a partir de 25 dólares por 5 IPs a las que sólo usted tiene acceso.

Si te interesan las IP residenciales, los precios empiezan en 250 dólares al mes por 10 proxies backconnect especiales, lo que significa que un servidor se encarga de la rotación de proxies, para que tú no tengas que molestarte.

Su grupo de proxy contiene más de 31 millones de IP, y los usuarios pueden ver el número exacto en su panel de control.

La orientación geográfica está disponible para cualquier país del mundo, pero hay una advertencia: sólo se puede utilizar con direcciones IP residenciales.

4. SmartProxy

Además de su impresionante conjunto de proxies, SmartProxy viene con una buena selección de herramientas. Estas son un generador de direcciones proxy, complementos para Chrome y Firefox, y un programa que te ayuda a navegar por la red desde varios navegadores simultáneamente.

Pero volvamos a los proxies. Smartproxy ofrece a sus usuarios acceso a más de 40 millones de IPs residenciales así como a 40k proxies de centros de datos. Además, también proporcionan proxies residenciales únicos diseñados para el scraping de motores de búsqueda. A diferencia de las otras dos opciones, cuyo precio depende del ancho de banda utilizado, los paquetes de proxy para buscadores tienen un número fijo de peticiones.

Aunque la mayoría de las IP proceden de EE.UU., Reino Unido, Canadá, Alemania, India y Japón, tienen más de cien ubicaciones con al menos 50 IP.

En cuanto al precio, hay paquetes desde 50 dólares por 100 GB de tráfico a través de proxies de centros de datos o 75 dólares por 5 GB con proxies residenciales. Como era de esperar, los planes más amplios tienen ofertas más ventajosas.

5. Datos brillantes

Bright Data pone sobre la mesa un impresionante conjunto de proxies compuesto por proxies de centros de datos, residenciales y móviles. En cifras, es así:

- Más de 700.000 IP de centros de datos

- Más de 72.000.000 de IP residenciales

- Más de 85.000 IP residenciales estáticas

- Más de 7.500.000 IP móviles

Grandes cantidades, sin duda. El inconveniente es que los precios también son bastante elevados. Aunque hay algunos paquetes con precios fijos, lo mejor es utilizar la calculadora de precios para crear un plan personalizado para ti. Con esta calculadora, estableces cuántas IP quieres y un ancho de banda máximo al mes, y recibirás el precio exacto.

En cuanto a la geolocalización, Bright Data tiene IP en casi todos los países del mundo. Tienen una página en su sitio web donde puedes comprobar las ubicaciones. Si necesitas ciertos tipos de proxies en áreas específicas, esa página te será útil.

Cómo elegir un proveedor de servicios proxy

Una de las ventajas más significativas del web scraping y de los proxies, en general, es la riqueza de opciones.

Como la mayoría de las personas o empresas tienen un objetivo concreto en mente, no es raro elegir un proveedor y luego darse cuenta de que no encaja. No es lo ideal, pero ocurre. Por suerte, la mayoría de las empresas tienen un periodo de prueba, un paquete gratuito o, al menos, una política de devolución del dinero.

Por eso, el mejor consejo que puedo darte es que explores tus opciones, mires escaparates y seguro que encuentras algo que te convenga.

Además de proxies, también necesitarás un raspador web, ¿verdad? Pues bien, de entre todas las alternativas, aquí tienes 10 productos de extracción de datos que merecen tu atención.

Si no tienes tiempo, aquí tienes una recomendación abreviada, sólo para ti: comienza tu prueba gratuita de WebScrapingAPI, ¡y no necesitarás probar otros scrapers!

Noticias y actualidad

Manténgase al día de las últimas guías y noticias sobre raspado web suscribiéndose a nuestro boletín.

Nos preocupamos por la protección de sus datos. Lea nuestra Política de privacidad.

Artículos relacionados

Explore las complejidades del scraping de datos de productos de Amazon con nuestra guía en profundidad. Desde las mejores prácticas y herramientas como Amazon Scraper API hasta las consideraciones legales, aprenda a superar los desafíos, eludir los CAPTCHA y extraer información valiosa de forma eficiente.

Explore el poder transformador del web scraping en el sector financiero. Desde datos de productos hasta análisis de opiniones, esta guía ofrece información sobre los distintos tipos de datos web disponibles para tomar decisiones de inversión.

¿Comparando Cheerio y Puppeteer para web scraping? Características, ventajas y diferencias. Consejos incluidos. Elija la mejor herramienta para usted.